Transformer架构是一种在自然语言处理(NLP)和其他形式的序列建模任务中广泛使用的深度学习模型。自2017年由Google的研究者提出以来,它已成为多种NLP应用的基石,包括机器翻译、文本生成和理解等。

发展背景

在Transformer之前,NLP领域主要依赖于循环神经网络(RNN)和长短期记忆网络(LSTM)等模型来处理序列数据。这些模型在处理长序列时存在一些限制,例如难以捕捉长距离依赖关系和较高的计算复杂度。Transformer的出现解决了这些问题,提供了一种更高效、更有效的方式来处理序列数据。

基本原理

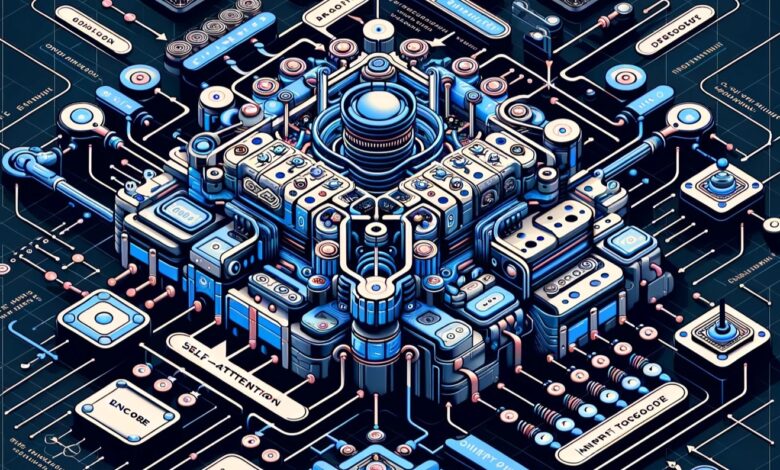

Transformer架构的核心是“自注意力机制”(self-attention mechanism),这种机制能够同时处理序列中的所有元素,并计算序列内各个部分之间的关联度。这种并行处理能力使Transformer比传统的序列处理模型更有效率。

Transformer架构通常包含两个主要部分:编码器(Encoder)和解码器(Decoder)。

- 编码器:负责处理输入数据,通过自注意力层和前馈网络生成中间表示。

- 解码器:利用编码器的输出和先前生成的输出元素来产生最终的输出序列。

关键特点

- 并行处理能力:能够同时处理整个序列,提高了模型的训练效率。

- 长距离依赖捕捉能力:自注意力机制使模型能够轻松捕捉长距离依赖关系。

- 灵活性和通用性:Transformer可以应用于各种序列建模任务,具有很高的灵活性。

应用

Transformer架构已经成为了许多NLP任务的基础,如:

- BERT(Bidirectional Encoder Representations from Transformers):用于文本分类、命名实体识别等。

- GPT(Generative Pre-trained Transformer):用于文本生成、问答系统等。

- 机器翻译:如Google的神经机器翻译系统。

挑战和未来方向

尽管Transformer架构非常强大,但它也存在一些挑战,如计算资源的大量需求和可能的过度拟合问题。未来的研究可能会集中在提高其效率、扩展应用范围以及解决目前存在的局限性上。

总之,Transformer架构是当前NLP领域的一个重要里程碑,它对语言模型和其他序列建模任务产生了深远影响。随着技术的不断进步,Transformer及其变体将继续在自然语言处理和相关领域中发挥关键作用。